ChatGPT利用人类反馈的强化学习

- 相机测评

- 用户投稿

- 2024-11-10 11:19:37

强化学习(ReinforcementLearning,RL)是一种机器学习的分支,它致力于研究如何在一个动态的环境中进行决策,以使得智能体可以获得最大的累积奖励。与传统的监督学习和无监督学习不同,RL的学习目标是通过与环境进行交互,从而学习到一个最优策略。在实际应用中,RL已经在许多领域中得到了广泛应用,比如控制、游戏、自然语言处理、机器人等。

RL在应用中也存在一些问题,比如:

RL需要花费大量的时间来学习一个最优策略;

RL的学习过程可能会受到噪声的影响,导致最终的策略并不是最优的;

RL的学习过程需要不断地与环境进行交互,这可能会导致一些不可预知的问题。

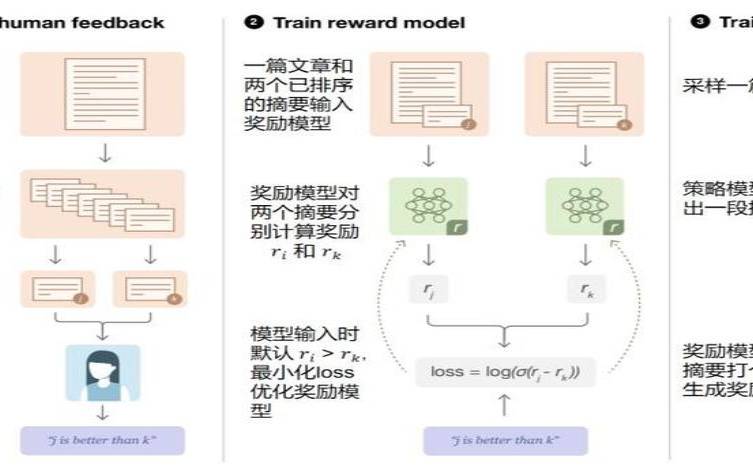

为了解决上述问题,研究人员提出了一种新的学习方式,即利用人类反馈的强化学习(ReinforcementLearningwithHumanFeedback,RLHF)。这种方法的基本思想是在RL的学习过程中,将人类专家的知识和经验融入到智能体的学习中,从而提高智能体的学习效率和性能。

在学习过程中,人类专家会对智能体的行为进行评估,并提供一些反馈信息;

智能体根据人类专家的反馈信息,调整自己的行为,并不断优化自己的策略;

当智能体的策略达到一定的水平时,人类专家可以对其进行终审,判断其是否达到了预期的效果。

相比传统的RL方法,RLHF的学习过程中融入了人类专家的知识和经验,可以提高智能体的学习效率和性能。同时,人类专家也可以通过监督智能体的学习过程,提高自己的专业知识和技能水平。

RLHF也存在一些问题。比如,人类专家的反馈信息可能存在误差和主观性,可能会对智能体的学习产生负面影响。此外,人类专家的参与也会增加成本和时间。因此,在实际应用中,需要仔细考虑如何平衡人类专家的参与和成本效益。

除了RLHF,还有一些其他的学习方法,也可以利用人类专家的知识和经验来加速学习过程,比如迁移学习、弱监督学习等。这些方法都可以在不同的应用场景中发挥作用,具有不同的优缺点。选择合适的学习方法,需要综合考虑数据量、人力成本、学习效率和性能等多个因素。

利用人类反馈的强化学习(RLHF)可以将人类专家的知识和经验融入到智能体的学习过程中,提高学习效率和性能。人类专家的反馈信息也可能存在误差和主观性,需要综合考虑其成本效益。在实际应用中,需要选择合适的学习方法,以满足不同应用场景的需求。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 1919100645@qq.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表