负载均衡的工作原理(nginx负载均衡原理)

- 相机测评

- 用户投稿

- 2024-11-16 11:57:44

负载均衡是一种常见的网络技术,用于将网络流量分散到多个服务器上,以提高系统的可用性和性能。在实际应用中,负载均衡可以通过多种方式来实现,下面将介绍几种常见的负载均衡实现方式。

硬件负载均衡是一种基于专用硬件设备的负载均衡实现方式,其主要目的是将网络流量分散到多个服务器上,以提高系统的可用性和性能。硬件负载均衡设备通常具有较高的性能和可靠性,可以支持较大的并发访问量,适用于对性能和可用性要求较高的应用场景。

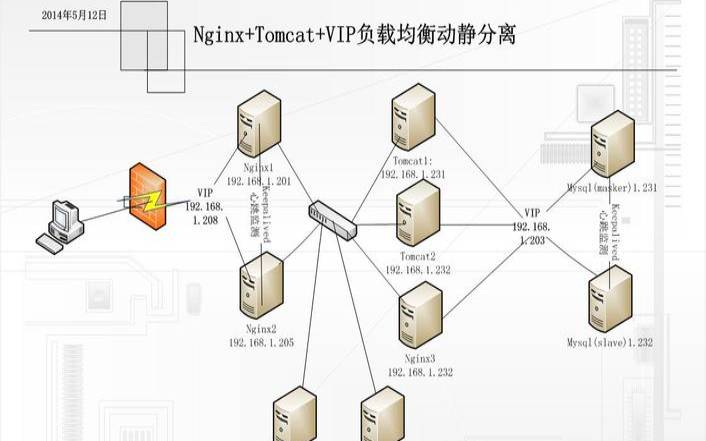

软件负载均衡是一种基于软件的负载均衡实现方式,其主要目的是将网络流量分散到多个服务器上,以提高系统的可用性和性能。软件负载均衡通常运行在普通的计算机系统上,通过软件实现负载均衡的功能。常见的软件负载均衡器包括Nginx、HAProxy、Apache等。软件负载均衡器具有成本低、易于部署和维护等优点,适用于各种规模的应用场景。

IP负载均衡是一种基于IP地址的负载均衡实现方式,其主要目的是将网络流量分散到多个服务器上,以提高系统的可用性和性能。IP负载均衡器通常使用ARP协议或者VRRP协议,将单个虚拟IP地址映射到多个物理服务器的IP地址上,使得客户端请求可以分散到多个服务器上。IP负载均衡器具有较好的性能和可用性,但是其缺点在于需要专用硬件支持,成本较高。

应用层负载均衡是一种基于应用层协议的负载均衡实现方式,其主要目的是将网络流量分散到多个服务器上,以提高系统的可用性和性能。应用层负载均衡器可以对请求进行识别和处理,并根据具体的业务逻辑将请求分发到多个服务器上。常见的应用层负载均衡器包括LVS、F5等。应用层负载均衡器具有较好的灵活性和可定制性,可以根据具体的应用需求进行配置和扩展。

需要注意的是,在选择负载均衡实现方式时,需要考虑多种因素,例如应用程序规模、性能需求、可用性要求、成本预算等等。不同的负载均衡实现方式具有不同的优缺点和适用场景,需要根据具体的应用需求进行选择。同时,在实际应用中,还需要进行系统性能测试和优化,以便获得更好的性能和稳定性。

负载均衡实现方式包括硬件负载均衡、软件负载均衡、DNS负载均衡、IP负载均衡和应用层负载均衡。每种实现方式都有其独特的优点和适用场景。在选择实现方式时,需要考虑应用需求和系统环境等因素,以便做出最合适的选择。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 1919100645@qq.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表