ai模型是什么意思(ai大模型有哪些)

- 相机测评

- 用户投稿

- 2024-11-17 09:25:18

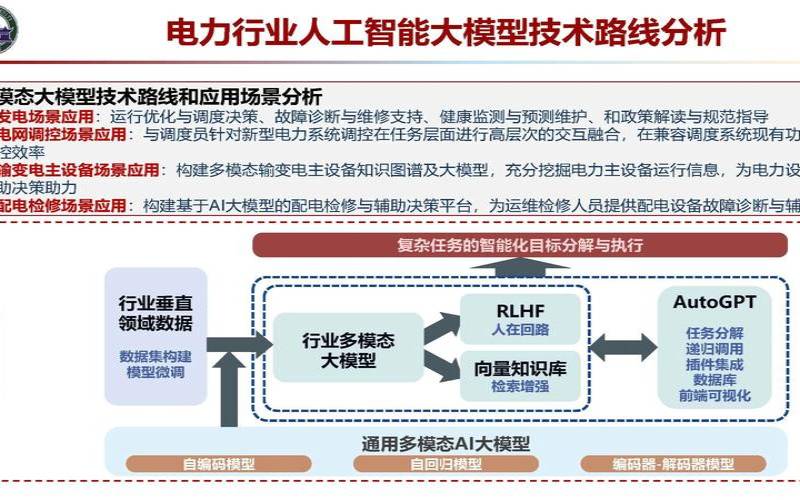

在深度学习领域,模型大小是一个非常重要的话题。在过去的几年中,随着神经网络模型的复杂度不断提高,模型大小也越来越大。这引发了一个争议:AI模型更大就更好吗?本文将探讨这个话题,并从多个角度来讨论AI模型大小的影响。

对于训练深度神经网络而言,模型大小确实是一个重要的因素。大模型可以提供更高的表现力,更好地捕捉数据中的模式和规律。这意味着模型可以更准确地预测数据,并且在训练集上表现得更好。同时,大模型也具有更好的泛化性能,可以更好地适应新的数据,从而在测试集上获得更好的表现。

大模型并不总是更好。一个过于庞大的模型不仅会增加训练时间和计算成本,还可能会导致过拟合。当模型过于复杂时,它可以记忆训练数据的特征而不是学习它们的本质,从而导致在新数据上的表现不佳。此外,大模型需要更多的存储空间和内存,这对于一些计算资源受限的场景可能会造成问题。

此外,对于一些特定的任务,例如自然语言处理(NLP)和计算机视觉(CV),已经出现了一些针对小型设备的特定模型。例如,MobileNet和ShuffleNet是一些针对移动设备的小型神经网络模型,它们的大小比大多数常用模型小得多,同时具有相似的准确性。

AI模型更大并不一定更好。虽然大型模型可以提供更高的表现力和更好的泛化性能,但它们需要更多的计算和存储资源,并且在一些场景下可能会导致过拟合。此外,在一些特定的任务和场景中,小型模型可以提供更好的性能和更高的效率。因此,对于选择一个适当的模型大小,需要综合考虑多个因素。

现在有一些技术可以帮助我们在不牺牲模型性能的情况下减少模型大小。一种常见的方法是模型压缩,包括权重剪枝、量化和知识蒸馏等。这些方法可以通过去除模型中不必要的参数,降低模型精度的位数,或者使用更小的模型来替代大模型来减小模型大小。

此外,深度学习研究中的一些新方法也有望减小模型的大小。例如,一些新的模型结构,如Transformer,可以在不增加模型大小的情况下提高模型性能。此外,一些新的神经网络架构搜索算法也可以生成更小的模型,同时具有与大模型相同的性能。

AI模型的大小是一个需要综合考虑多个因素的问题。大型模型可以提供更高的表现力和更好的泛化性能,但需要更多的计算和存储资源,并且在一些场景下可能会导致过拟合。小型模型可以提供更高的效率和更好的适应性,但需要权衡性能和资源使用。在选择模型大小时,需要根据具体的应用场景和计算资源情况来综合考虑多个因素,并利用一些压缩和优化技术来帮助减小模型大小,提高模型性能和效率。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 1919100645@qq.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表