语言模型是什么(语言生成模型)

- 相机测评

- 用户投稿

- 2024-05-15 13:13:08

大语言模型是近年来人工智能领域中的重要研究方向。它通过利用深度学习技术,构建起了一个庞大、复杂的神经网络,可以自动地学习语言的规律和模式,从而生成人类可读的自然语言。在本文中,我们将对大语言模型的发展历程进行概述。

在计算机科学早期,基于n-gram的语言模型是一种常见的统计语言模型。它通过统计一个词或者一组词在语言中出现的频率,来计算一个句子的概率。这种方法虽然简单,但是在语言模型的设计中起到了重要作用。

随着深度学习技术的发展,基于神经网络的语言模型开始受到广泛关注。这种方法使用一个深度神经网络来学习语言的规律和模式。在这个神经网络中,每个词被表示为一个向量,然后将它们送入神经网络进行训练。这种方法可以避免使用n-gram方法中需要存储的大量数据,从而大大提高了语言模型的性能和效率。

为了解决RNN语言模型中的梯度消失和梯度爆炸等问题,长短时记忆网络(LSTM)被引入到语言模型中。LSTM可以更好地捕捉长序列中的依赖关系,从而提高了模型的性能和泛化能力。

人工智能算法:卷1基础算法+卷2受大自然启发的算法+卷3深度学习和神经网络(京东套装3册)(异步图书

门控循环单元(GRU)是LSTM的一个变种,它可以在更简单的结构下实现类似的处理效果。与LSTM相比,GRU模型的参数更少,训练速度更快,因此在一些应用场景中表现更优。

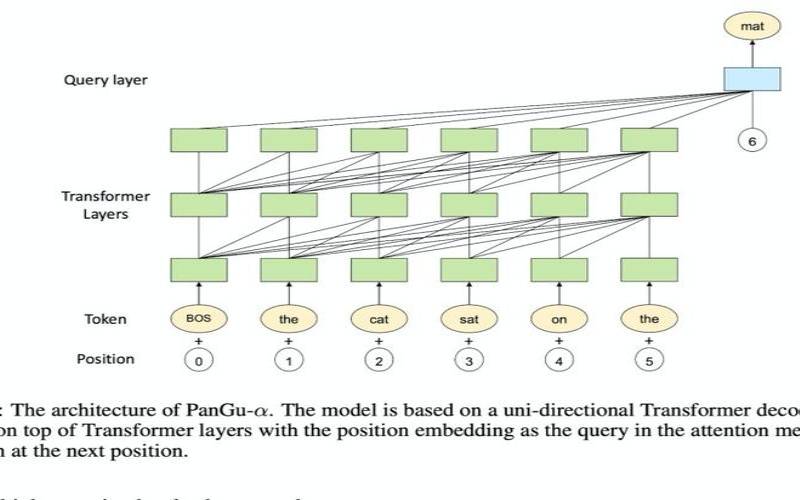

近年来,大规模预训练语言模型(pre-trainedlanguagemodels)已经成为了大语言模型的主流发展方向。这种方法通过在大规模文本数据上进行自监督学习,构建一个预训练的语言模型,并在此基础上进行微调,来完成各种自然语言处理任务。例如,BERT、GPT和XLNet等模型已经在各种自然语言处理任务中取得了很好的表现。

大语言模型的发展经历了从基于n-gram的语言模型到基于神经网络的语言模型,再到递归神经网络语言模型、LSTM语言模型和GRU语言模型等不同阶段的发展。在未来,随着技术的不断进步和新的研究方法的出现,大语言模型的性能和应用范围还将继续扩展和提高。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 1919100645@qq.com 举报,一经查实,本站将立刻删除。

下一篇

返回列表